В мире искусственного интеллекта, где модели вроде GPT-4 и Claude демонстрируют поразительные способности к генерации текста и решению сложных задач, иногда случаются курьезные промахи, превращающиеся в вирусные мемы. Одним из таких ярких примеров стала неспособность этих “всезнающих” систем написать простое слово – “клубника”. Именно количество букв “r” в этом фруктовом названии стало неожиданным барьером для продвинутых алгоритмов.

Проблема не в знании, а в архитектуре

Секрет этой странной неудачи кроется не в недостатке знаний у ИИ, а в самой сути его работы. Большинство современных языковых моделей (LLM) основаны на архитектуре “трансформер”, которая, по сути, не читает текст так, как мы. Вместо этого она преобразует его в числовые кодировки. Представьте, что слово “the” для модели – это не набор букв “t”, “h”, “e”, а всего лишь одна уникальная цифровая метка, обозначающая его значение.

Когда вы вводите запрос, он преобразуется в кодировку. Когда он видит слово “the”, у него есть только одна кодировка того, что означает “the”, но он не знает о “T”, “H”, “E”.

Таким образом, модель понимает семантику слова, его контекст и связь с другими словами, но не обладает внутренним представлением о буквах как таковых. Она знает, что “солома” и “ягода” составляют “клубнику”, но не может перечислить буквы, из которых оно состоит.

Токенизация: путь к пониманию или барьер?

Еще одна сложность заключается в токенизации – процессе разбиения текста на отдельные единицы (токены). В английском языке это обычно слова или части слов, но для языков без пробелов между словами (китайский, японский и др.) эта задача усложняется.

Как отмечает Йенни Джун из Google DeepMind, для передачи одного и того же смысла на некоторых языках требуется в 10 раз больше токенов, чем на английском. Идеального способа токенизации не существует, поскольку сама природа языка неоднозначна.

Генераторы изображений: иной подход

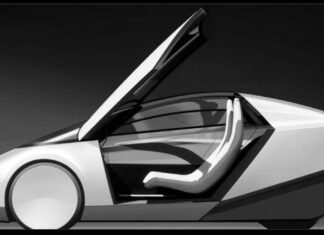

В отличие от текстовых моделей, генераторы изображений, такие как Midjourney и DALL-E, используют диффузионные модели. Они обучаются на огромных базах данных изображений и “восстанавливают” картинку из шума, пытаясь воспроизвести увиденное.

Мелаш Тека Хадгу, соучредитель Lesan и научный сотрудник Института DAIR, поясняет: “Генераторы изображений лучше справляются с объектами, как автомобили или лица людей, но хуже с мелкими деталями, например, пальцами или почерком. Это связано с тем, что такие детали не так часто выделяются в обучающих наборах данных.”

Подобные проблемы с диффузионными моделями, возможно, легче устранить, чем у трансформаторов. Обучение на большем количестве изображений реальных рук уже позволило некоторым генераторам улучшить их воспроизведение.

Надежда на “Клубнику”: Новые горизонты для ИИ

Мемы о неспособности написать “strawberry” стимулируют развитие. OpenAI работает над новым продуктом под кодовым названием “Strawberry”, который, как ожидается, будет более искусным в рассуждениях и понимании структурных элементов языка.

Ключевой аспект “Strawberry” – генерация точных синтетических данных для обучения LLM. По слухам, эта модель сможет решать кроссворды “Connections” из New York Times, требующие творческого мышления и распознавания образов, а также математические задачи, с которыми ранее не сталкивалась.

Параллельно Google DeepMind представила AlphaProof и AlphaGeometry 2 – системы ИИ, решающие формальные математические задачи. Они даже завоевали серебряную медаль на Международной математической олимпиаде, решив четыре из шести задач.

Эти достижения показывают, что путь к более глубокому пониманию языка и мира у ИИ продолжается. Возможно, вскоре “клубника” перестанет быть загадкой для этих интеллектуальных систем.