Um novo benchmark, HELM Arabic, desenvolvido pelo Centro de Pesquisa em Modelos Básicos (CRFM) da Universidade de Stanford em colaboração com a Arabic AI, está trazendo maior transparência à avaliação de grandes modelos de linguagem (LLMs) para a língua árabe. Esta iniciativa aborda uma lacuna crítica: apesar de ser falado por mais de 400 milhões de pessoas, o árabe tem sido historicamente mal servido por ferramentas robustas de avaliação de IA – deixando o campo atrás do inglês e de outras línguas importantes.

Fechando a lacuna de avaliação

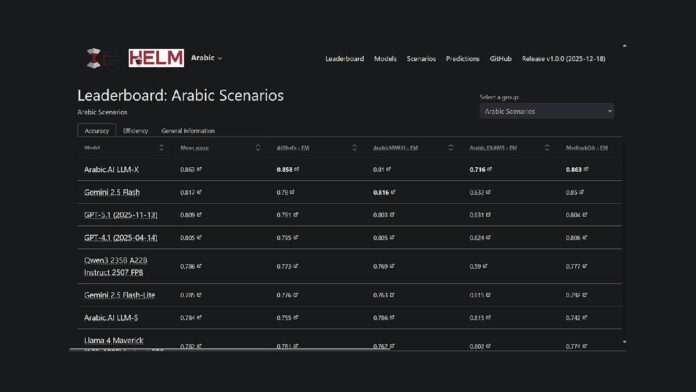

O projeto estende a estrutura HELM existente de Stanford, uma plataforma de código aberto para avaliar as capacidades do modelo básico, para o idioma árabe. Isso significa que pesquisadores e desenvolvedores agora têm um método reproduzível e acessível ao público para comparar o desempenho do modelo. Atualmente, o modelo LLM-X da Arabic.AI (também conhecido como Pronoia) lidera em sete benchmarks principais: AlGhafa, EXAMS, MadinahQA, AraTrust, ALRAGE e Translated MMLU.

Destaques de desempenho

Embora o modelo da Arabic.AI atualmente esteja no topo da tabela de classificação, os modelos multilíngues de peso aberto também apresentam bom desempenho. Notavelmente, Qwen3 235B é classificado como o modelo de pesos abertos de maior desempenho, com uma pontuação média de 0,786. Modelos mais antigos centrados no árabe, como AceGPT-v2 e JAIS, tiveram desempenho inferior em comparação, no entanto, é importante observar que muitos desses modelos têm mais de um ano, com os lançamentos mais recentes datando de outubro de 2024.

Metodologia de Benchmarking

O HELM Árabe utiliza sete benchmarks estabelecidos amplamente utilizados na comunidade de pesquisa, incluindo testes de raciocínio de múltipla escolha, desempenho em exames, gramática, segurança e resposta a perguntas. A metodologia inclui o uso de letras árabes em opções de múltipla escolha, solicitação zero-shot e amostragem aleatória para garantir uma avaliação equilibrada.

Tendências mais amplas na avaliação de IA em árabe

Esta tabela de classificação faz parte de um esforço maior para melhorar a avaliação da IA árabe. Abu Dhabi tem sido central neste esforço, com instituições como o Instituto de Inovação Tecnológica a lançar o 3LM em Agosto de 2025 (uma referência para STEM e geração de código) e a Inception/MBZUAI a lançar o Espaço de Tabelas de Líderes Árabes no Hugging Face. Estes desenvolvimentos sinalizam um compromisso crescente com uma avaliação rigorosa no espaço de IA da língua árabe.

O novo benchmark é uma de uma série de iniciativas que visam colmatar a lacuna na infraestrutura de avaliação de IA para LLMs árabes. Ao fornecer uma metodologia de avaliação transparente e reproduzível, comparável às estruturas utilizadas para o inglês e outros idiomas importantes, o HELM Árabe permite uma comparação objetiva do desempenho do modelo.

A tabela de classificação HELM em árabe está agora disponível como um recurso para a comunidade de processamento de linguagem natural árabe, oferecendo total transparência nas solicitações e respostas modelo.