Nowy benchmark, HELM Arabic, opracowany przez Centrum Badań nad Modelami Podstawowymi (CRFM) Uniwersytetu Stanforda we współpracy z arabską sztuczną inteligencją, ma na celu poprawę przejrzystości w ocenie dużych modeli językowych (LLM) dla języka arabskiego. Inicjatywa ta ma na celu usunięcie krytycznej luki: mimo że ponad 400 milionów ludzi posługuje się nim ponad 400 milionów ludzi, w przeszłości język arabski był niedostatecznie wspierany przez solidne narzędzia oceny sztucznej inteligencji, które pozostawały w tyle za angielskim i innymi głównymi językami.

Zamknięcie luki w ocenie

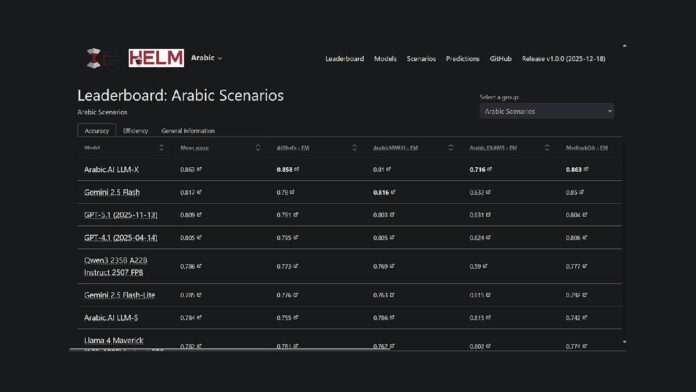

Projekt rozszerza istniejącą platformę HELM firmy Stanford – platformę typu open source do oceny możliwości podstawowych modeli – na język arabski. Oznacza to, że badacze i programiści mają teraz publicznie dostępną, powtarzalną metodę porównywania wydajności modeli. Obecnie model LLM-X firmy Arabic.AI (znany również jako Pronoia) przoduje w siedmiu kluczowych wskaźnikach: AlGhafa, EXAMS, MadinahQA, AraTrust, ALRAGE i Translated MMLU.

Kluczowe wskaźniki wydajności

Choć obecnie na szczycie rankingów znajduje się model Arabic.AI, dobrze radzą sobie także modele o otwartej wadze, obsługujące wiele języków. Co najważniejsze, Qwen3 235B zajmuje pierwsze miejsce wśród modeli o otwartej wadze ze średnim wynikiem 0,786. Starsze modele skupiające się na języku arabskim, takie jak AceGPT-v2 i JAIS, radziły sobie gorzej, jednak należy zauważyć, że wiele z tych modeli ma ponad rok, a najnowsze wydania datowane są na październik 2024 r.

Metodologia benchmarkingu

HELM Arabic wykorzystuje siedem ustalonych standardów szeroko stosowanych w społeczności naukowej, w tym testy wielokrotnego wyboru na rozumowanie, wyniki egzaminów, gramatykę, bezpieczeństwo i odpowiadanie na pytania. Metodologia obejmuje użycie liter arabskich w opcjach wielokrotnego wyboru, zapytaniach otwartych i losowym próbowaniu w celu zapewnienia zrównoważonej oceny.

Szersze trendy w ocenie arabskiej sztucznej inteligencji

Ranking ten jest częścią większego ruchu mającego na celu poprawę oceny arabskiej sztucznej inteligencji. Abu Zabi odgrywa kluczową rolę w tych wysiłkach, a instytucje takie jak Instytut Innowacji Technologicznych wypuszczają 3LM w sierpniu 2025 r. (punkt odniesienia dla STEM i generowania kodu) oraz Inception/MBZUAI uruchamiają arabską przestrzeń liderów na Hugging Face. Zmiany te sygnalizują rosnące zaangażowanie w rygorystyczną ocenę w dziedzinie arabskiej sztucznej inteligencji.

Nowy benchmark jest jedną z inicjatyw mających na celu wypełnienie luki w infrastrukturze oceny sztucznej inteligencji dla arabskich firm LLM. Zapewniając przejrzystą, powtarzalną metodologię oceny porównywalną z metodami stosowanymi w języku angielskim i innych głównych językach, HELM Arabic umożliwia obiektywne porównanie wydajności modelu.

Wynik HELM Arabic jest teraz dostępny jako źródło informacji dla społeczności przetwarzającej arabski język naturalny, zapewniając pełną przejrzystość zapytań i odpowiedzi dotyczących modeli.