Een nieuwe benchmark, HELM Arabic, ontwikkeld door Stanford University’s Centre for Research on Foundation Models (CRFM) in samenwerking met Arabische AI, zorgt voor meer transparantie in de evaluatie van grote taalmodellen (LLM’s) voor de Arabische taal. Dit initiatief pakt een kritieke leemte aan: ondanks dat het door meer dan 400 miljoen mensen wordt gesproken, wordt het Arabisch historisch gezien onvoldoende ondersteund door robuuste AI-beoordelingsinstrumenten, waardoor het vakgebied achterblijft bij het Engels en andere grote talen.

Het dichten van de evaluatiekloof

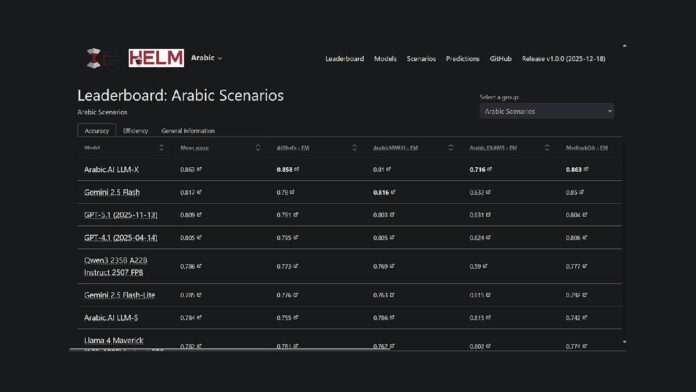

Het project breidt het bestaande HELM-framework van Stanford, een open-sourceplatform voor het beoordelen van de mogelijkheden van funderingsmodellen, uit naar de Arabische taal. Dit betekent dat onderzoekers en ontwikkelaars nu een publiek toegankelijke, reproduceerbare methode hebben om de prestaties van modellen te vergelijken. Momenteel loopt het LLM-X-model van Arabic.AI (ook bekend als Pronoia) voorop in zeven belangrijke benchmarks: AlGhafa, EXAMS, MadinahQA, AraTrust, ALRAGE en Translated MMLU.

Prestatiehoogtepunten

Hoewel het model van Arabic.AI momenteel bovenaan het klassement staat, presteren meertalige modellen met een open gewicht ook goed. Opvallend is dat de Qwen3 235B het best presterende model met open gewicht is, met een gemiddelde score van 0,786. Oudere, op het Arabisch gerichte modellen, zoals AceGPT-v2 en JAIS, presteerden in vergelijking ondermaats. Het is echter belangrijk op te merken dat veel van deze modellen meer dan een jaar oud zijn, waarbij de meest recente releases dateren uit oktober 2024.

Benchmarkingmethodologie

HELM Arabic maakt gebruik van zeven gevestigde benchmarks die veel worden gebruikt in de onderzoeksgemeenschap, waaronder tests voor meerkeuzeredenen, examenprestaties, grammatica, veiligheid en het beantwoorden van vragen. De methodologie omvat het gebruik van Arabische letters in meerkeuzeopties, zero-shot prompting en willekeurige steekproeven om een evenwichtige evaluatie te garanderen.

Bredere trends in Arabische AI-evaluatie

Dit klassement maakt deel uit van een groter initiatief om de Arabische AI-beoordeling te verbeteren. Abu Dhabi heeft een centrale rol gespeeld in deze inspanning, waarbij instellingen als het Technology Innovation Institute in augustus 2025 3LM uitbrachten (een benchmark voor STEM en codegeneratie) en Inception/MBZUAI de Arabische Leaderboards Space on Hugging Face lanceerden. Deze ontwikkelingen duiden op een groeiende inzet voor rigoureuze evaluatie in de AI-ruimte in de Arabische taal.

De nieuwe benchmark is een van een aantal initiatieven die tot doel hebben de kloof in de AI-evaluatie-infrastructuur voor Arabische LLM’s te dichten. Door een transparante, reproduceerbare evaluatiemethodologie te bieden die vergelijkbaar is met de raamwerken die worden gebruikt voor Engels en andere belangrijke talen, maakt HELM Arabic een objectieve vergelijking van de modelprestaties mogelijk.

Het HELM Arabische scorebord is nu beschikbaar als hulpmiddel voor de Arabische natuurlijke-taalverwerkingsgemeenschap en biedt volledige transparantie in modelverzoeken en -antwoorden.