Un nuovo benchmark, HELM Arabic, sviluppato dal Centro di ricerca sui modelli di fondazione (CRFM) dell’Università di Stanford in collaborazione con Arabic AI, sta apportando maggiore trasparenza alla valutazione dei modelli linguistici di grandi dimensioni (LLM) per la lingua araba. Questa iniziativa colma una lacuna critica: nonostante sia parlato da oltre 400 milioni di persone, l’arabo è stato storicamente poco servito da robusti strumenti di valutazione dell’intelligenza artificiale, lasciando il campo in ritardo rispetto all’inglese e ad altre lingue principali.

Colmare il divario di valutazione

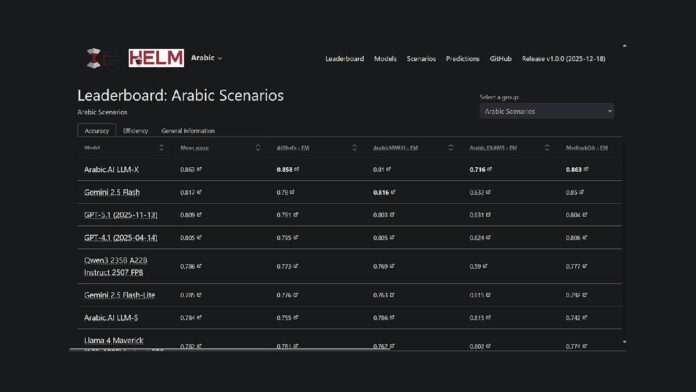

Il progetto estende il framework HELM esistente di Stanford, una piattaforma open source per la valutazione delle capacità del modello di fondazione, alla lingua araba. Ciò significa che ricercatori e sviluppatori ora dispongono di un metodo accessibile al pubblico e riproducibile per confrontare le prestazioni dei modelli. Attualmente, il modello LLM-X di Arabic.AI (noto anche come Pronoia) supera sette benchmark chiave: AlGhafa, EXAMS, MadinahQA, AraTrust, ALRAGE e Translated MMLU.

Punti salienti delle prestazioni

Sebbene il modello di Arabic.AI sia attualmente in cima alla classifica, anche i modelli multilingue a peso aperto stanno ottenendo buoni risultati. In particolare, Qwen3 235B si classifica come il modello a pesi aperti con le prestazioni più elevate con un punteggio medio di 0,786. I modelli più vecchi incentrati sull’arabo, come AceGPT-v2 e JAIS, hanno sottoperformato in confronto, tuttavia, è importante notare che molti di questi modelli hanno più di un anno, con le versioni più recenti risalenti all’ottobre 2024.

Metodologia di benchmarking

HELM Arabic utilizza sette parametri di riferimento consolidati ampiamente utilizzati nella comunità di ricerca, inclusi test per ragionamento a scelta multipla, rendimento degli esami, grammatica, sicurezza e risposta alle domande. La metodologia prevede l’utilizzo di lettere arabe in opzioni a scelta multipla, suggerimenti zero-shot e campionamento casuale per garantire una valutazione equilibrata.

Tendenze più ampie nella valutazione dell’IA araba

Questa classifica fa parte di un impegno più ampio volto a migliorare la valutazione dell’intelligenza artificiale in arabo. Abu Dhabi ha avuto un ruolo centrale in questo sforzo, con istituzioni come il Technology Innovation Institute che hanno rilasciato 3LM nell’agosto 2025 (un punto di riferimento per STEM e generazione di codici) e Inception/MBZUAI che hanno lanciato l’Arab Leaderboards Space on Hugging Face. Questi sviluppi segnalano un impegno crescente verso una valutazione rigorosa nello spazio dell’intelligenza artificiale in lingua araba.

Il nuovo benchmark è una delle numerose iniziative volte a colmare il divario nell’infrastruttura di valutazione dell’intelligenza artificiale per gli LLM arabi. Fornendo una metodologia di valutazione trasparente e riproducibile paragonabile ai framework utilizzati per l’inglese e altre lingue principali, HELM Arabic consente un confronto oggettivo delle prestazioni del modello.

La classifica araba HELM è ora disponibile come risorsa per la comunità di elaborazione del linguaggio naturale arabo, offrendo piena trasparenza nelle richieste e nelle risposte dei modelli.