Un nouveau benchmark, HELM Arabic, développé par le Centre de recherche sur les modèles de base (CRFM) de l’Université de Stanford en collaboration avec Arabic AI, apporte une plus grande transparence à l’évaluation des grands modèles linguistiques (LLM) pour la langue arabe. Cette initiative comble une lacune critique : bien qu’il soit parlé par plus de 400 millions de personnes, l’arabe a toujours été mal desservi par des outils d’évaluation de l’IA robustes, laissant ce domaine à la traîne par rapport à l’anglais et à d’autres langues majeures.

Combler les lacunes en matière d’évaluation

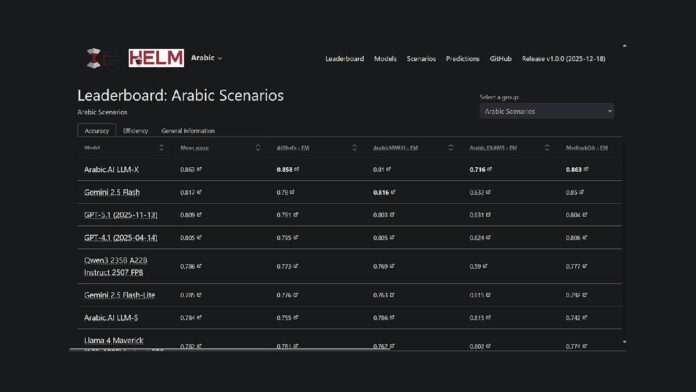

Le projet étend le cadre HELM existant de Stanford, une plate-forme open source pour évaluer les capacités des modèles de fondation, à la langue arabe. Cela signifie que les chercheurs et les développeurs disposent désormais d’une méthode reproductible et accessible au public pour comparer les performances des modèles. Actuellement, le modèle LLM-X d’Arabic.AI (également connu sous le nom de Pronoia) est en tête sur sept références clés : AlGhafa, EXAMS, MadinahQA, AraTrust, ALRAGE et Translated MMLU.

Points forts des performances

Alors que le modèle Arabic.AI est actuellement en tête du classement, les modèles multilingues à poids ouvert fonctionnent également bien. Notamment, le Qwen3 235B se classe comme le modèle à poids ouvert le plus performant avec un score moyen de 0,786. Les modèles plus anciens centrés sur l’arabe, tels que AceGPT-v2 et JAIS, ont sous-performé en comparaison. Cependant, il est important de noter que bon nombre de ces modèles ont plus d’un an, les versions les plus récentes remontant à octobre 2024.

Méthodologie d’analyse comparative

HELM Arabic utilise sept critères établis largement utilisés dans la communauté de recherche, notamment des tests de raisonnement à choix multiples, de performance aux examens, de grammaire, de sécurité et de réponse aux questions. La méthodologie comprend l’utilisation de lettres arabes dans les options à choix multiples, les invites à tir nul et l’échantillonnage aléatoire pour garantir une évaluation équilibrée.

Tendances plus larges dans l’évaluation de l’IA en arabe

Ce classement fait partie d’un effort plus large visant à améliorer l’évaluation de l’IA en arabe. Abu Dhabi a joué un rôle central dans cet effort, avec des institutions telles que le Technology Innovation Institute qui a lancé 3LM en août 2025 (une référence pour les STEM et la génération de code) et Inception/MBZUAI qui ont lancé l’Arabic Leaderboards Space on Hugging Face. Ces développements témoignent d’un engagement croissant en faveur d’une évaluation rigoureuse dans l’espace de l’IA en langue arabe.

Le nouveau référentiel est l’une des nombreuses initiatives visant à combler le fossé dans l’infrastructure d’évaluation de l’IA pour les LLM arabes. En fournissant une méthodologie d’évaluation transparente et reproductible comparable aux cadres utilisés pour l’anglais et d’autres langues principales, HELM Arabic permet une comparaison objective des performances du modèle.

Le classement HELM arabe est désormais disponible en tant que ressource pour la communauté de traitement du langage naturel arabe, offrant une transparence totale sur les modèles de demandes et de réponses.