Un nuevo punto de referencia, HELM árabe, desarrollado por el Centro de Investigación sobre Modelos Fundamentales (CRFM) de la Universidad de Stanford en colaboración con Arab AI, está aportando mayor transparencia a la evaluación de grandes modelos lingüísticos (LLM) para el idioma árabe. Esta iniciativa aborda una brecha crítica: a pesar de ser hablado por más de 400 millones de personas, el árabe históricamente no ha contado con sólidas herramientas de evaluación de IA, lo que ha dejado el campo rezagado respecto del inglés y otros idiomas importantes.

Cerrando la brecha de evaluación

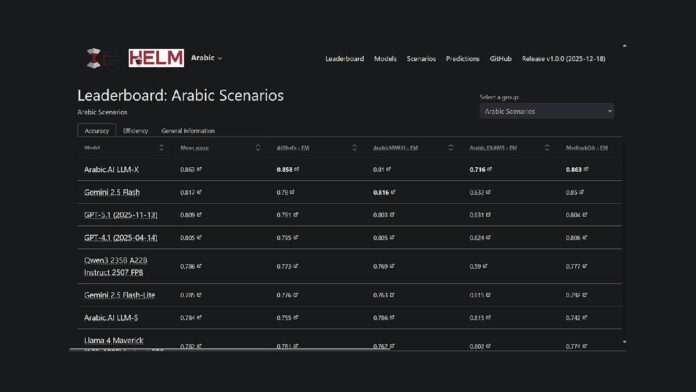

El proyecto amplía el marco HELM existente de Stanford, una plataforma de código abierto para evaluar las capacidades del modelo básico, al idioma árabe. Esto significa que los investigadores y desarrolladores ahora tienen un método reproducible y de acceso público para comparar el rendimiento del modelo. Actualmente, el modelo LLM-X de Arab.AI (también conocido como Pronoia) lidera siete puntos de referencia clave: AlGhafa, EXAMS, MadinahQA, AraTrust, ALRAGE y Translated MMLU.

Aspectos destacados del rendimiento

Si bien el modelo de Arab.AI encabeza actualmente la clasificación, los modelos multilingües de peso abierto también están funcionando bien. En particular, el Qwen3 235B se ubica como el modelo de peso abierto de mayor rendimiento con una puntuación media de 0,786. Los modelos más antiguos centrados en árabe, como AceGPT-v2 y JAIS, tuvieron un rendimiento inferior en comparación; sin embargo, es importante tener en cuenta que muchos de estos modelos tienen más de un año y los lanzamientos más recientes se remontan a octubre de 2024.

Metodología de evaluación comparativa

HELM Árabe utiliza siete puntos de referencia establecidos ampliamente utilizados en la comunidad de investigación, incluidas pruebas de razonamiento de opción múltiple, desempeño en exámenes, gramática, seguridad y respuesta a preguntas. La metodología incluye el uso de letras árabes en opciones de opción múltiple, indicaciones de respuesta cero y muestreo aleatorio para garantizar una evaluación equilibrada.

Tendencias más amplias en la evaluación de la IA en árabe

Esta tabla de clasificación es parte de un esfuerzo mayor para mejorar la evaluación de la IA árabe. Abu Dabi ha sido fundamental en este esfuerzo, con instituciones como el Instituto de Innovación Tecnológica que lanzaron 3LM en agosto de 2025 (un punto de referencia para STEM y generación de código) y Inception/MBZUAI que lanzó el espacio de tablas de clasificación árabe en Hugging Face. Estos desarrollos indican un compromiso creciente con una evaluación rigurosa en el espacio de la IA en idioma árabe.

El nuevo punto de referencia es una de una serie de iniciativas que tienen como objetivo cerrar la brecha en la infraestructura de evaluación de IA para los LLM árabes. Al proporcionar una metodología de evaluación transparente y reproducible comparable a los marcos utilizados para el inglés y otros idiomas principales, HELM árabe permite una comparación objetiva del rendimiento del modelo.

La tabla de clasificación árabe de HELM ahora está disponible como recurso para la comunidad de procesamiento del lenguaje natural árabe y ofrece total transparencia en las solicitudes y respuestas modelo.