Ein neuer Benchmark, HELM Arabic, der vom Center for Research on Foundation Models (CRFM) der Stanford University in Zusammenarbeit mit Arabic AI entwickelt wurde, sorgt für mehr Transparenz bei der Bewertung großer Sprachmodelle (LLMs) für die arabische Sprache. Diese Initiative schließt eine kritische Lücke: Obwohl Arabisch von über 400 Millionen Menschen gesprochen wird, wurde es in der Vergangenheit von robusten KI-Bewertungstools nicht ausreichend unterstützt – so dass der Bereich hinter Englisch und anderen wichtigen Sprachen zurückbleibt.

Die Bewertungslücke schließen

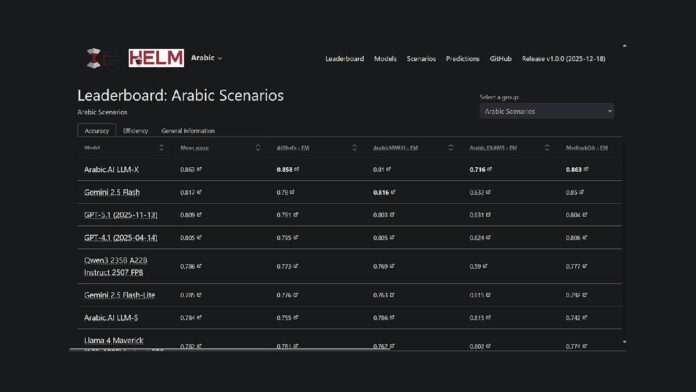

Das Projekt erweitert Stanfords bestehendes HELM-Framework, eine Open-Source-Plattform zur Bewertung der Fähigkeiten von Stiftungsmodellen, in die arabische Sprache. Dies bedeutet, dass Forscher und Entwickler nun über eine öffentlich zugängliche, reproduzierbare Methode zum Vergleich der Modellleistung verfügen. Derzeit ist das LLM-X-Modell (auch bekannt als Pronoia) von Arabic.AI in sieben wichtigen Benchmarks führend: AlGhafa, EXAMS, MadinahQA, AraTrust, ALRAGE und Translated MMLU.

Leistungshighlights

Während das Modell von Arabic.AI derzeit die Bestenliste anführt, schneiden auch mehrsprachige Modelle mit offenem Gewicht gut ab. Bemerkenswert ist, dass Qwen3 235B mit einem Durchschnittswert von 0,786 das leistungsstärkste Modell mit offenen Gewichten ist. Ältere arabisch-zentrierte Modelle wie AceGPT-v2 und JAIS schnitten im Vergleich schlechter ab. Es ist jedoch wichtig zu beachten, dass viele dieser Modelle über ein Jahr alt sind und die neuesten Veröffentlichungen auf Oktober 2024 zurückgehen.

Benchmarking-Methodik

HELM Arabic nutzt sieben etablierte Benchmarks, die in der Forschungsgemeinschaft weit verbreitet sind, darunter Tests für Multiple-Choice-Argumentation, Prüfungsleistung, Grammatik, Sicherheit und Fragenbeantwortung. Die Methodik umfasst die Verwendung arabischer Buchstaben in Multiple-Choice-Optionen, Zero-Shot-Eingabeaufforderungen und Zufallsstichproben, um eine ausgewogene Bewertung sicherzustellen.

Breitere Trends in der arabischen KI-Bewertung

Diese Bestenliste ist Teil einer größeren Initiative zur Verbesserung der arabischen KI-Bewertung. Abu Dhabi spielte bei diesen Bemühungen eine zentrale Rolle: Institutionen wie das Technology Innovation Institute veröffentlichten im August 2025 3LM (einen Maßstab für STEM und Codegenerierung) und Inception/MBZUAI startete den Arabic Leaderboards Space auf Hugging Face. Diese Entwicklungen signalisieren ein wachsendes Engagement für eine strenge Bewertung im KI-Bereich der arabischen Sprache.

Der neue Benchmark ist eine von mehreren Initiativen, die darauf abzielen, die Lücke in der KI-Bewertungsinfrastruktur für arabische LLMs zu schließen. Durch die Bereitstellung transparenter, reproduzierbarer Bewertungsmethoden, die mit den für Englisch und andere wichtige Sprachen verwendeten Frameworks vergleichbar sind, ermöglicht HELM Arabic einen objektiven Vergleich der Modellleistung.

Die HELM-Rangliste für Arabisch ist jetzt als Ressource für die arabische Community zur Verarbeitung natürlicher Sprache verfügbar und bietet vollständige Transparenz über Modellanfragen und -antworten.