Nový benchmark, HELM Arabic, vyvinutý Centrem pro výzkum základních modelů Stanfordské univerzity (CRFM) ve spolupráci s arabskou AI, má za cíl zlepšit transparentnost při hodnocení velkých jazykových modelů (LLM) pro arabštinu. Tato iniciativa řeší kritickou mezeru: přestože jí mluví více než 400 milionů lidí, arabština byla historicky nedostatečně podporována robustními nástroji pro hodnocení umělé inteligence, která zaostává za angličtinou a dalšími hlavními jazyky.

Překonání mezery v hodnocení

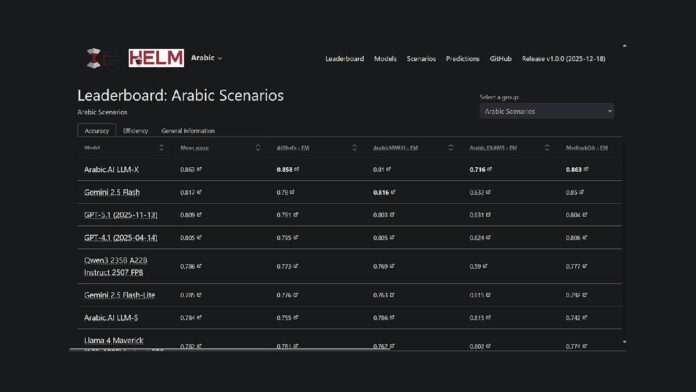

Projekt rozšiřuje stávající rámec Stanfordu HELM, open-source platformu pro hodnocení schopností základních modelů, do arabštiny. To znamená, že výzkumníci a vývojáři nyní mají veřejně dostupnou, reprodukovatelnou metodu pro porovnávání výkonu modelu. V současné době vede model LLM-X od Arabic.AI (také známý jako Pronoia) v sedmi klíčových metrikách: AlGhafa, EXAMS, MadinahQA, AraTrust, ALRAGE a Translated MMLU.

Klíčové ukazatele výkonu

Zatímco model Arabic.AI v současnosti vede žebříček, dobře fungují i modely s otevřenou váhou, které podporují více jazyků. Nejpozoruhodnější je, že Qwen3 235B se řadí na první místo mezi modely s otevřenou váhou s průměrným skóre 0,786. Starší modely zaměřené na arabštinu, jako jsou AceGPT-v2 a JAIS, fungovaly hůře, je však důležité poznamenat, že mnoho z těchto modelů je více než rok starých, přičemž nejnovější verze se datují do října 2024.

Metodologie benchmarkingu

HELM Arabic používá sedm zavedených benchmarků široce používaných ve vědecké komunitě, včetně testů uvažování s výběrem odpovědí, výkonu zkoušek, gramatiky, bezpečnosti a zodpovězení otázek. Metodika zahrnuje použití arabských písmen v možnostech výběru z více možností, otevřených dotazech a náhodném výběru vzorků, aby bylo zajištěno vyvážené hodnocení.

Širší trendy v hodnocení arabské umělé inteligence

Tento žebříček je součástí většího hnutí za zlepšení hodnocení arabské umělé inteligence. Abu Dhabi hraje v tomto úsilí ústřední roli, přičemž instituce jako Technology Innovation Institute vydaly v srpnu 2025 3LM (benchmark pro STEM a generování kódu) a Inception/MBZUAI spustily Arabic Leaderboards Space on Hugging Face. Tento vývoj signalizuje rostoucí závazek k přísnému hodnocení v oblasti arabské umělé inteligence.

Nový benchmark je jednou z iniciativ zaměřených na řešení mezery v infrastruktuře hodnocení AI pro arabské LLM. Tím, že poskytuje transparentní, reprodukovatelnou metodiku hodnocení srovnatelnou s metodikou používanou pro angličtinu a další hlavní jazyky, umožňuje HELM Arabic objektivní srovnání výkonnosti modelu.

Arabské skóre HELM je nyní k dispozici jako zdroj pro komunitu zpracování arabského přirozeného jazyka a poskytuje úplnou transparentnost modelových dotazů a odpovědí.